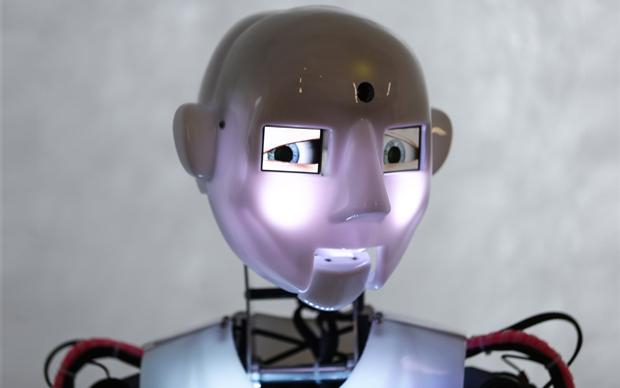

Können diese Augen lügen?

Sie werden ja immer schlauer, die Roboter. Aber ihnen das Lügen beizubringen, will noch nicht so recht klappen. Dafür fehlt es ihnen einfach an Mitgefühl

Eugene Goostman ist ein mittelmäßiger Lügner. Als 13-Jähriger sollte er das mit dem Lügen inzwischen eigentlich gelernt haben. Im Gespräch wirkt der junge Ukrainer unsicher, versteht Fragen nicht, wechselt häufig das Thema, erzählt Belanglosigkeiten. Eminem mag er, „Star Wars“ findet er eher mäßig. Er wirkt fahrig. Er wirkt wie einer, dem es an irgendetwas fehlt, um mit der nötigen Geschicklichkeit auch mal nicht die Wahrheit zu sagen.

Statt aus Fleisch und Blut besteht Eugene aus Einsen und Nullen. Er ist ein Computerprogramm, entwickelt, um Menschen vorzugaukeln, er sei einer von ihnen. Ausgerechnet diese Täuschung gilt in der Forschung als ein Beweis für künstliche Intelligenz. Der Mathematiker Alan Turing entwarf bereits 1950 einen Test dafür, bestehend aus einem Fragesteller und zwei Gesprächspartnern – einer menschlich und einer maschinell. Die Aufgabe des Fragenden ist es herauszufinden, wer nur vorgibt, ein Mensch zu sein. Nach Auffassung vieler Wissenschaftler ist der Test bestanden, wenn mehr als 50 Prozent der Probanden davon überzeugt sind, dass es sich auch beim Computerprogramm um einen Menschen handelt.

Klingt eigentlich gar nicht so kompliziert, doch die Aufgabe gilt auch 64 Jahre nach ihrem ersten Durchlauf als nicht befriedigend gelöst. „Den Maschinen fehlen einfach die Emotionen und die Empathie“, erklärt Raúl Rojas, Robotik-Experte, Professor für künstliche Intelligenz an der Freien Universität Berlin und momentan Visiting Fellow an der Princeton University.

Und Emotionen braucht man, um lügen zu können. Denn genauer betrachtet ist die Lüge eine der höchsten kognitiven Herausforderungen überhaupt. Zum Erfolg braucht es nicht nur eine gute Geschichte. Sie muss auch an den Informationsstand und den kritischen Geist des Gegenübers angepasst sein. So brauchen wir Menschen einige Lehrzeit, bis wir es schaffen, problemlos zu lügen. Kinder beginnen zwar schon im Alter von zwei Jahren, spielerisch zu flunkern, allerdings vor allem, weil sie Fantasie und Wirklichkeit noch nicht richtig auseinanderhalten können. Erst mit etwa fünf Jahren ist das kindliche Bewusstsein so weit entwickelt, dass der Nachwuchs gezielt ausprobiert, ob er mit Lügen Erfolg hat.

Sexualpartner werden gerne hinters Licht geführt

Der Hauptgrund für diese „schleppende“ Entwicklung: Um sich in einer Situation zwischen Lüge und Wahrheit zu entscheiden, braucht es eine Vorstellung über die Erwartungen des Gegenübers. Wissenschaftler sprechen dabei von der „Theory of Mind“. Die Möglichkeit, sich in jemand anderen hineinzuversetzen, haben laut gängiger Lehrmeinung nur Menschen und einige Menschenaffenarten. Maschinen hingegen überhaupt nicht. „Sprache in Worte umsetzen, Gesichter erkennen oder Fahrzeuge steuern, das alles ist für Maschinen halbwegs lösbar. Bei Emotionen und zwischenmenschlichen Beziehungen stößt die künstliche Intelligenz dagegen schnell an ihre Grenzen“, erklärt Rojas.

Ein kleiner Lichtblick: Wenigstens den Lug und Trug des Tierreichs können Roboter schon nachahmen. In der Natur ist Täuschen allgegenwärtig. Vor allem Fresskonkurrenz, Beute und Sexualpartner werden gerne hinters Licht geführt. Eichhörnchenarten schützen zum Beispiel ihre Nussvorräte durch Scheinverstecke. Forscher der Wilkes-Universität in Philadelphia beobachteten Grauhörnchen dabei, wie sie Löcher gruben und anschließend nur so taten, als würden sie eine Nuss hineinschieben. Besonders häufig zeige sich dieses trügerische Verhalten, wenn Artgenossen in der Nähe sind, schreiben Michael Steele und Kollegen im Fachjournal „Animal Behaviour“.

Der Robotik-Forscher Ronald Arkin vom Georgia Institute of Technology konnte dieses Verhalten mit Maschinen nachahmen. Zusammen mit seinem Team ließ er zwei autonome Roboter gegeneinander antreten. Der erste sammelte fleißig Pappscheiben-Futter und brachte es in seine Verstecke. Wie sein Grauhörnchen-Vorbild ließ er einige leer. Nach dem Verstecken bewachte er die Beute und fuhr zwischen den Vorräten hin und her. Der zweite Roboter irrte zunächst zufällig auf dem Spielfeld herum, bis er den Sammler entdeckte – und diesem dann gezielt zu den Verstecken folgte. Der „Sammler“ begann daraufhin, ganz wie das Grauhörnchen, Scheinverstecke anzusteuern, den Räuber immer im Schlepptau. Der erfolglose Räuber verliert sein Interesse. Kein betrügerisches Meisterstück, trotzdem in seiner Entwicklung mathematisch hochkomplex. Anders ausgedrückt: Mit Hilfe von Interaktionsmatrizen aus der Spieltheorie berechnen die Roboter alle möglichen Reaktionen des Gegenübers im Voraus.

Lügen hilft im Service

So bleibt der lügende Roboter vorerst eine Utopie, vielleicht auch zum Glück. Die grundlegende Beschäftigung mit der Unehrlichkeit von Maschinen ist jedoch nur konsequent. „Für eine Lüge muss man sich perfekt in sein Gegenüber hineinversetzen können. Genau das wäre für die Schnittstelle zwischen Mensch und Maschine äußerst erstrebenswert“, erklärt Rojas. Ein Beispiel dafür ist das „Verständnis“ von Emotionen. Seit Jahren versuchen Wissenschaftler, dem Computer die Emotionen von Menschen verständlich zu machen. Zum Beispiel durch die Interpretation der Augenbrauen-Stellung oder des Tonfalls der Stimme. Wir Menschen erkennen meistens schnell, wenn unser Gesprächspartner schlechte Laune hat oder müde ist, und können darauf reagieren. Service-Roboter, mechanische Pflegekräfte oder automatische Hotline-Systeme würden von solchen Fähigkeiten profitieren. Laut Prognose des VDMA- Fachverbandes Robotik + Automation verspricht der Markt für solche Systeme in den nächsten Jahren ein immenses Wachstum. In Japan wirken erste Roboter in Pflegeheimen mit, und Nestlé plant, Roboter als Verkäufer einzusetzen.

Aus der Sicht von Rojas bleibt auf dem Weg zum empathischen Gegenüber aus Nullen und Einsen eine große, kaum überwindbare Hürde. Die Roboter müssten für ein tieferes Verständnis Emotionen fühlen. Unglück oder Trauer ließen sich schließlich nur verstehen, wenn man selbst in der Lage ist, solche Gefühle zu empfinden. „Doch genau das können und brauchen Maschinen nicht. Sie müssen keine Angst vor dem Tod oder einer Trennung haben. Ihr System wird neu gestartet“, sagt der Robotik-Forscher.

Birk Grüling ist einer, der es lieber mit der Wahrheit hält. Er ist im niedersächsischen Niemandsland aufgewachsen, hat Kultur-Journalismus studiert und schreibt als freier Journalist unter anderem für die „Zeit“, die „taz„, jetzt.de und Spiegel Online. 2014 wurde er vom Medium Magazin unter die Top 30 der Nachwuchsjournalisten gewählt.