Wann Algorithmen transparent sein sollten – und wann nicht

Algorithmen können entscheiden, ob wir einen Kredit oder einen Job bekommen. Wie man sie kontrollieren kann – und warum sie auch geschützt werden müssen, erklärt die Informatik-Professorin Katharina A. Zweig

fluter.de: Sie haben die Initiative AlgorithmWatch mitbegründet. Was macht Algorithmen heute so mächtig, dass man sie beobachten sollte?

Katharina Zweig: Algorithmen ersetzen mehr und mehr menschliche Experten, um vorherzusagen, wie sich Menschen verhalten werden. Aufgrund dieser Prognosen können Entscheidungen getroffen werden, etwa ob jemand einen Kredit bekommt oder zu einem Jobinterview eingeladen wird. Da Algorithmen auch nur von Menschen gemacht sind, können sie sich aber genau wie sie irren. Im Moment ist es jedoch sehr schwierig zu durchschauen, ob sie sich irren. Deshalb ist es wichtig, dass da jemand regelmäßig draufschaut.

In der Vergangenheit haben Algorithmen sogar Dinge getan, die wir als diskriminierend empfinden. Wie passiert denn so etwas?

Es gibt einige Beispiele, wo Algorithmen sexistisch oder rassistisch sind. Eine Studie hat ermittelt, dass weibliche Surfer im Netz weniger gut bezahlte Jobangebote angezeigt bekommen als männliche. Oder wer in den USA einen afrikanischen Vornamen eingab, dem wurde durch das Schalten von entsprechenden Werbeanzeigen suggeriert, es gäbe einen Datenbank-Eintrag zu Haftstrafen dieser Person, auch wenn da keine waren. Da hat der Algorithmus etwas gelernt, was das Verhalten der Gesellschaft momentan widerspiegelt. Es ist ja gerade so, dass Frauen die schlechteren Jobs haben und daher wahrscheinlich auf weniger gute Jobanfragen klicken.

Der Algorithmus zementierte also Vorurteile.

Genau das ist das Problem. Wenn die Daten, die reingehen, ein Vorurteil oder eine Diskriminierung beinhalten, dann lernt der Algorithmus die mit. Das ist wie mit einem Kind. Wenn man dem nur Vorurteile mitgibt, dann wird es die später wohl auch haben. Sich davon zu emanzipieren ist für einen Algorithmus jedoch nicht möglich.

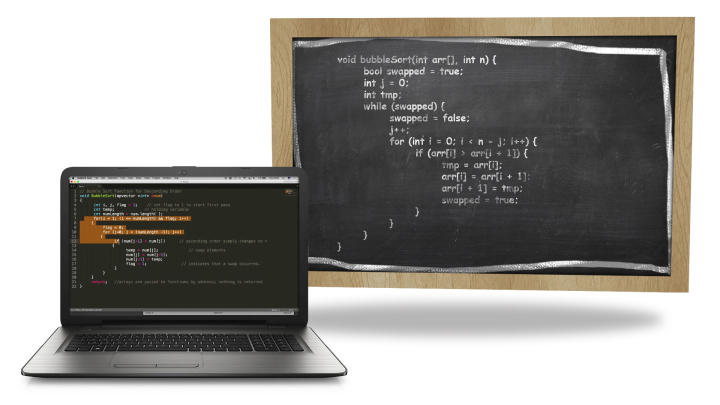

Wissen denn die Programmierer überhaupt, wie ihre Programme auf so etwas kommen?

Das weiß man bei lernenden Algorithmen nicht hundertprozentig. Also, man könnte es sich manchmal denken, wenn man über die speziellen Fälle nachdenkt: Gerade das Beispiel mit den Frauen und den Jobs zeigt ja, dass der Algorithmus eigentlich gut lernt. Aber eben auch, dass wir diesen jetzigen Zustand der Gesellschaft nicht weiter fördern wollen. Generell ist das wie mit Kindern. Wir können nicht zu 100 Prozent beeinflussen, welcher Umwelt sie ausgesetzt sind. Am Anfang behütet man sie, korrigiert sie und gibt ihnen Möglichkeiten zu lernen, aber irgendwann müssen sie raus, und da weiß man nicht so genau, wie sie sich entwickeln. Ähnlich ist es mit den Algorithmen. Wenn die unter schlechten Daten trainiert werden, dann kann es sein, dass sie Muster entdecken, wo keine sind, ein bisschen wie ein abergläubischer Mensch. Oder dass sie Muster nicht entdecken.

Ab wann sollten Algorithmen denn kontrolliert werden?

Wenn Facebook sagt, wir sortieren die Nachrichten nach Relevanz, dann wüsste man gern, was die darunter verstehen. Könnte es etwa sein, dass neben der Relevanz der Nachrichten ein weiteres Kriterium die Zeit ist, die wir auf der Plattform bleiben sollen? Dagegen ist ja grundsätzlich nichts einzuwenden. Das ist ein Unternehmen, das ein Eigeninteresse hat. Aber es wäre wichtig, dass uns dargestellt wird, was der Algorithmus genau tut. Grundsätzlich müssen wir uns überlegen, bei welchen Algorithmen wir einen gesellschaftlichen Anspruch auf Transparenz haben. Ich denke, dass das eher wenige sind.

Welche denn?

Auf jeden Fall solche, die Menschen kategorisieren. Das können medizinische Algorithmen sein, die den Arzt darauf hinweisen, ob auf Röntgenbildern ein Tumor ist, das könnte die Kreditvergabe sein, die Studienplatzvergabe, alles, was im arbeitsrechtlichen Bereich liegt, wo etwa die Leistung von Arbeitnehmern automatisch bewertet werden soll.

Nun lassen sich Facebook oder Google ungern in die Karten schauen. Wie realistisch ist es denn, dass Internetgiganten Einblick in ihre Formeln gewähren?

Google gibt eigentlich schon jetzt ziemlich viel über seinen Suchmaschinen-Algorithmus preis. Das hat dazu geführt, dass es einen neuen Beruf gibt, den Suchmaschinenoptimierer, der Firmen dabei hilft, dass ihre Website möglichst gut bei bestimmten Suchanfragen angezeigt wird. Sehr viel transparenter dürfte Google daher auch gar nicht werden.

Warum?

Denn dann würden dauernd Spamwebseiten nach oben gehen. Auch für uns als Gesellschaft ist es daher in manchen Fällen wichtig, dass es eine Balance zwischen Offenheit und Geheimhaltung gibt.

Algorithmen müssen also auch geschützt werden?

Ja. Das ist ganz wichtig. Es wäre gar nicht gut, wenn etwa Betrüger wüssten, wie jeder Algorithmus funktioniert. Es ist auch wichtig, dass kein Innovationshemmnis entsteht. Es gibt viele spannende Informatik-Start-ups, denen mit zu viel Regulierung nicht geholfen wäre. Dafür ein Beispiel: Grundsätzlich könnten Suchmaschinen ja auch eine politische Agenda haben und die eine oder andere Partei besser darstellen als die anderen. Wenn es aber dafür keinen Verdachtsmoment gibt und die Suchmaschine aktuell nur wenige Leute erreicht – hat die Gesellschaft dann schon einen Anspruch darauf, kostspielige Code-Inspektionen zu verlangen? Das müssen wir als Gesellschaft vorsichtig diskutieren.

Wie könnte ein transparenterer Umgang mit Algorithmen aussehen?

Ich kann mir zwei Dinge vorstellen. Wir bräuchten vielleicht ein neues Berufsbild. Jemand, der Algorithmen unabhängig kontrolliert. So eine Situation hatten wir schon mal, nämlich als der Beruf des Wirtschaftsprüfers in den 1930er-Jahren entstand. Der schaut sich die Zahlen von Unternehmen an, eigentlich ein Geheimnis, und darf natürlich nichts darüber sagen, wenn er die Firma verlässt.

Und die andere Idee?

Google und Facebook sind im US-Wahlkampf viel angegriffen worden, der einen oder anderen Seite geholfen zu haben. Ich bin mir gar nicht so sicher, ob die sich nicht selbst dafür interessieren, ein unabhängiges Siegel zu bekommen.

Das sind ja alles internationale Firmen. Hat die EU da überhaupt die Mittel, das von diesen Firmen zu verlangen?

Richtig rechtlich durchsetzen können wir auf jeden Fall im Moment nicht alles. Nun sind aber Firmen wie Google oder Facebook darauf angewiesen, dass die Menschen sie weiterhin benutzen. Deshalb wäre es wichtig, mal zu formulieren, wie wir als Gesellschaft es denn gerne hätten. Ich hatte bisher den Eindruck, dass das schon gehört wird. Diskussionen wie die über Hate Speech ändern Dinge bei den großen Firmen. Aber die Algorithmen, um die es uns bei AlgorithmWatch geht, die sind teils versteckter. Das sind welche, die die Kreditwürdigkeit berechnen, die vielleicht – wir wissen es nicht – von Geheimdiensten eingesetzt werden, um Terrorverdächtige herauszufiltern. Da müssen wir als Bürger wirklich darauf pochen, dass da irgendjemand Einblick bekommt.

Wer müsste sich darum kümmern?

Es müsste eine unabhängige Institution sein, die in die kleine Teilmenge der potenziell gesellschaftlich relevanten Algorithmen reinschauen können sollte. Und möglichst auch einen Forschungsauftrag hat. Denn was wir auch nicht vergessen dürfen: Gesellschaft ändert sich, und zwar rasant. In den 1970ern hätte mein Mann noch meinen Arbeitsvertrag kündigen dürfen. Jeder Algorithmus, der damals programmiert worden wäre und die damaligen Ideen über Gesellschaft enthält, den würden wir heute natürlich nicht mehr verwenden wollen.

Wenn Algorithmen immer mehr Entscheidungen treffen, müsste man sie dann verklagen können?

Ja und nein. Ich als Mutter bin teilweise verantwortlich für die Handlungen meiner Kinder. Irgendwo hört aber meine Verantwortung auf. Es gibt ein schönes Beispiel von Microsoft. Die hatten einen Chatbot, der sollte in einem Chatforum mitdiskutieren, in dem er zuhört und lernt, was die Leute sagen, und sich dann im Internet passende Textschnipsel sucht. Der hat fantastisch funktioniert. Leider aber fanden die Leute in dem Chatforum es lustig, ihn auf rechtsradikal zu bürsten. Nach kurzer Zeit hat er schlimme Sprüche rausgehauen. Ist Microsoft dafür verantwortlich, dass sie keine Ausnahme für diese Themen einprogrammiert haben? Definitiv haben sie sich verantwortlich dafür gefühlt. Der Chatbot war schnell raus aus dem Netz. Auf der anderen Seite hat die Gesellschaft – also die Nutzer des Chatforums – dazu beigetragen. Rein rechtlich kann man auch den Programmierern das nicht zur Gänze anlasten.

Das klingt nicht so einfach.

Ist es auch nicht. Aber es gibt Analogien. Wenn jemand sein Kind stramm rechts oder extrem links erzieht und es dann mit 17 Jahren Leute verkloppt, da bin ich mir auch nicht sicher, wer dann den Großteil der Schuld kriegt. Das Kind? Die Eltern? Darüber müssen wir auch bei Algorithmen reden.